File robots.txt được biết đến như là một công cụ không thể thiếu đối với SEOer, giúp bạn quản lý và kiểm soát cách các công cụ tìm kiếm thu thập và lập chỉ mục nội dung trên website. Vậy File robots.txt là gì? Cách thức hoạt động ra sao? Nên lưu ý gì khi sử dụng? Dưới đây là những thông tin cụ thể giúp bạn tận dụng robots.txt file đạt hiệu quả SEO tốt nhất.

1. Tìm hiểu về file robots.txt

File robots.txt là một công cụ hữu ích đóng vai trò chiến lược trong SEO. Nếu biết cách ứng dụng tốt công cụ này, bạn sẽ giúp website của mình hoạt động hiệu quả hơn. Vậy File robots.txt là gì?

1.1. File robots.txt là gì?

File robots.txt là tệp văn bản nằm trong thư mục gốc của website, chứa các chỉ dẫn dành cho các bot của công cụ tìm kiếm như Google, Bing,… về cách thức mà bot có thể thu thập dữ liệu trên trang của bạn. Tức là tệp này sẽ cho các bot biết những URL nào được phép truy cập và những URL nào bị hạn chế.

Nhìn chung, chức năng chính của file robots.txt chính là ngăn cản các bot gửi quá nhiều yêu cầu cùng lúc cho trang web cùng một lúc, nhằm tiết kiệm tài nguyên và duy trì hiệu suất ổn định cho máy chủ. Tuy nhiên, việc chặn một trang trong robots.txt không đảm bảo trang đó sẽ hoàn toàn không xuất hiện trên kết quả tìm kiếm. Nguyên nhân là bởi vì các trang khác vẫn có thể liên kết đến nó. Nó hoàn toàn có khả năng được lập chỉ mục thông qua các liên kết bên ngoài.

1.2. Vị trí của file robots.txt

Dành cho những ai chưa biết, file robots.txt chuẩn đặt ở thư mục gốc của website. Điều này nhằm đảm bảo công cụ tìm kiếm có thể dễ dàng tìm thấy và truy cập vào trang. Vị trí của tệp này ở:

| https://www.example.com/robots.txt |

Trong đó, example.com là tên miền của bạn. Việc đặt file robots.txt ngay tại thư mục gốc của website cho phép công cụ tìm kiếm truy cập trực tiếp vào tệp ngay khi ghé thăm website. Điều này đảm bảo rằng các quy tắc bạn đã thiết lập sẽ được áp dụng một cách chính xác.

Trong tình huống bạn đặt file robots.txt ở một vị trí khác hay trong thư mục con, ví dụ: https://www.example.com/folder/robots.txt. Lúc này, các bot sẽ không thể tìm thấy tệp, do đó, không thể thực hiện theo các quy tắc bên trong. Chính vì thế, quy tắc quan trọng mà SEOer cần tuân thủ, đó chính là đặt file robots.txt tại thư mục gốc của tên miền.

1.3. Kiểm tra website đã có file robots.txt chưa

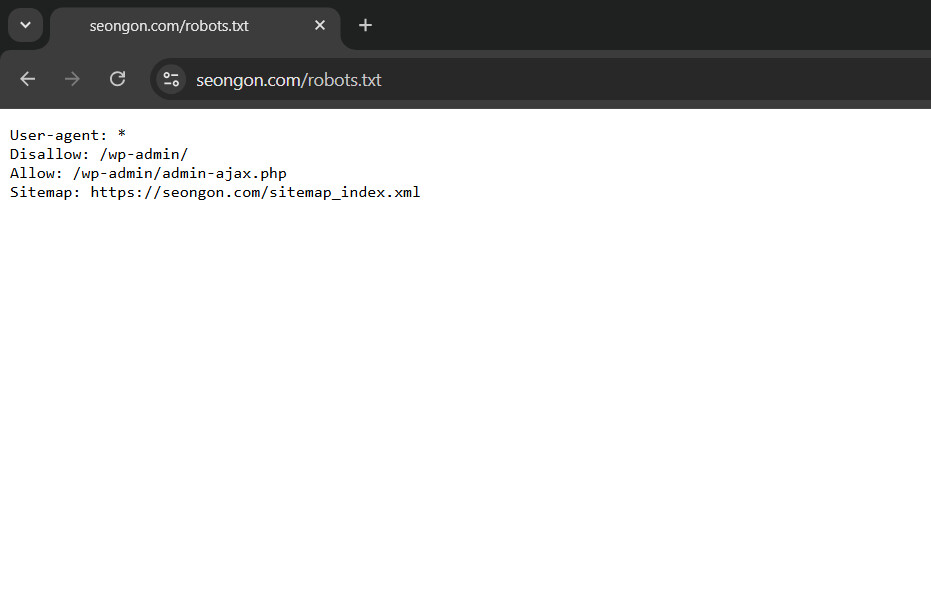

Để kiểm tra, bạn mở thanh tìm kiếm của trình duyệt, gõ chính xác địa chỉ của tệp robots.txt theo cú pháp sau:

| https://seongon.com/robots.txt |

Hãy thay “seongon.com” bằng tên miền website bạn muốn kiểm tra. Sau đó, hãy nhấn enter, trình duyệt sẽ tự động truy cập và hiển thị nội dung của tệp robots.txt nếu nó tồn tại. Nếu không, bạn sẽ thấy trang báo lỗi 404 hoặc một thông báo cho biết rằng file này không có sẵn.

2. Định dạng chuẩn của file robots.txt

Khi thiết lập file robots.txt, việc hiểu rõ định dạng chuẩn là rất quan trọng nhằm đảm bảo rằng các bot có thể hiểu và tuân theo các quy tắc bạn đã thiết lập.

2.1. Cấu trúc cơ bản của file robot.txt

File robots.txt có cấu trúc đơn giản, gồm các chỉ dẫn cơ bản dành cho các bot tìm kiếm. Dưới đây là 4 cú pháp bạn sẽ bắt gặp trong một file robot.txt.

User-agent: Xác định bot nào sẽ bị ảnh hưởng bởi các quy tắc tiếp theo. Mỗi bot tìm kiếm đều có một tên riêng, ví dụ:

| User-agent: Googlebot |

Disallow: Ngăn bot tìm kiếm truy cập vào một URL hoặc một thư mục cụ thể. Ví dụ, với các thiết lập bên dưới có thể hiểu là một yêu cầu bot tìm kiếm không được truy cập vào thư mục /admin/.

| Disallow: /admin/ |

Allow: Bot được phép vào một URL hoặc thư mục nhất định. Mặc dù ít được sử dụng hơn, nhưng chỉ dẫn này có thể giúp mở quyền truy cập vào các tài nguyên quan trọng. Ví dụ, quy tắc dưới cho phép bot được truy cập vào thư mục /images/.

| Allow: /images/ |

Sitemap: Chỉ ra vị trí của tệp sitemap.xml, giúp công cụ tìm kiếm tìm thấy bản đồ cấu trúc website dễ dàng hơn.

| Sitemap: https://example.com/sitemap.xml |

2.2. Định dạng file robot.txt đầy đủ

Dưới đây là một ví dụ điển hình về file robots.txt đầy đủ với các chỉ dẫn cho công cụ tìm kiếm:

| User-agent: Googlebot

Disallow: /admin/ Disallow: /cgi-sys/ Disallow: /temp/ Disallow: *.php~ Allow: /images/ Sitemap: https://example.com/sitemap.xml User-agent: Bingbot Disallow: /private/ |

Trong ví dụ trên:

- Googlebot bị chặn truy cập vào các thư mục /admin/, /cgi-sys/, /temp/ và các tệp có phần mở rộng .php~. Tuy nhiên, Googlebot được phép truy cập vào thư mục /images/.

- Bingbot không được phép truy cập vào thư mục /private/.

- Cả Googlebot và Bingbot đều nhận được thông báo về vị trí của tệp sitemap.xml để thu thập dữ liệu hiệu quả hơn.

Qua đó, có thể thấy rằng File robots.txt là một công cụ hữu ích giúp SEOer kiểm soát cách các bot tìm kiếm và tương tác với website của mình một cách hiệu quả hơn. File này cũng đảm bảo rằng chỉ trang quan trọng của website mới được lập chỉ mục hay thu thập dữ liệu từ công cụ tìm kiếm.

3. Tác động của file robots.txt đến các loại tệp

File robots.txt có nhiệm vụ quan trọng trong việc quản lý cách thức công cụ tìm kiếm truy cập và thu thập dữ liệu trên website. Dưới đây là các tác dụng chính của file robots.txt đối với các loại tệp trên website:

3.1. Trang web

- Điều phối lưu lượng truy cập: file robots.txt cho phép bạn giới hạn việc truy cập của bot vào các trang nhất định, giúp giảm tải cho máy chủ và đảm bảo tài nguyên của website không bị sử dụng quá mức. Điều này đặc biệt hữu ích khi bạn lo ngại về tình trạng quá tải từ các trình thu thập dữ liệu.

- Ngăn thu thập các trang không quan trọng hoặc trùng lặp: người dùng có thể sử dụng robots.txt để chặn các trang không cần thiết, ví dụ như các trang phụ hoặc trang có nội dung trùng lặp. Điều này không chỉ giúp giảm khối lượng dữ liệu được thu thập mà còn giúp tối ưu hóa tài nguyên của website.

- Không phải phương tiện để ẩn trang: mặc dù robots.txt giúp kiểm soát quyền truy cập của các bot nhưng không phải là cách đảm bảo để ẩn một trang khỏi kết quả tìm kiếm. Các công cụ tìm kiếm khác vẫn có thể lập chỉ mục URL của các trang bị chặn nếu có liên kết từ các trang khác liên kết đến kèm mô tả. Nếu bạn muốn hiển thị trang trên kết quả tìm kiếm, bạn cần dùng thẻ noindex hoặc thiết lập mật khẩu bảo vệ trang.

3.2. Tệp đa phương tiện (hình ảnh, video, âm thanh)

Ngăn xuất hiện trong kết quả tìm kiếm: file robots.txt có thể được sử dụng để ngăn các tệp đa phương tiện, bao gồm hình ảnh, video hoặc âm thanh xuất hiện trong kết quả tìm kiếm của Google (cũng như các công cụ tìm kiếm khác). Điều này hữu ích khi bạn muốn giữ riêng tư hoặc không muốn các tệp này bị sao chép trái phép. Song, việc này chỉ khiến chúng không hiển thị trong kết quả tìm kiếm chứ không ngăn người dùng hoặc các trang web khác liên kết trực tiếp tới các tệp này.

3.3. Tệp tài nguyên (CSS, JavaScript, hình ảnh, v.v.)

Quản lý tài nguyên không quan trọng: file robots.txt cũng có thể được sử dụng để chặn các tệp tài nguyên phụ không ảnh hưởng nhiều đến hoạt động chính của trang web, giúp giảm tải cho các trình thu thập dữ liệu (ảnh nền, script phụ,…). Song, hãy lưu ý rằng không nên chặn các tài nguyên quan trọng như CSS hoặc JavaScript chính của trang. Nguyên nhân vì những tệp này giúp Google hiểu rõ cách trang hiển thị và hoạt động. Việc chặn những tệp này có thể dẫn đến việc Google hiểu sai về cấu trúc trang và ảnh hưởng đến thứ hạng.

4. Những hạn chế của tệp robots.txt

Mặc dù tệp robots.txt là công cụ hữu ích giúp bạn quản lý quyền truy cập của các trình thu thập dữ liệu, nhưng nó cũng có những hạn chế nhất định. Dưới đây là 4 hạn chế lớn nhất của công cụ này.

4.1. Giới hạn cho một số công cụ tìm kiếm

Các quy tắc trong robots.txt không phải đều được tất cả công cụ tìm kiếm tuân thủ. Cụ thể, trong khi các công cụ tìm kiếm lớn như Googlebot thường tuân thủ các quy tắc trong robots.txt thì không phải tất cả các bot đều làm như vậy. Nhiều bot, đặc biệt là các bot không đáng tin cậy hoặc các bot chuyên dụng cho mục đích thu thập dữ liệu không hợp pháp có thể không tuân thủ một phần hoặc bỏ qua hoàn toàn quy tắc của bạn. Điều này làm cho việc các tệp bị chặn vẫn bị thu thập dữ liệu hoặc lập chỉ mục.

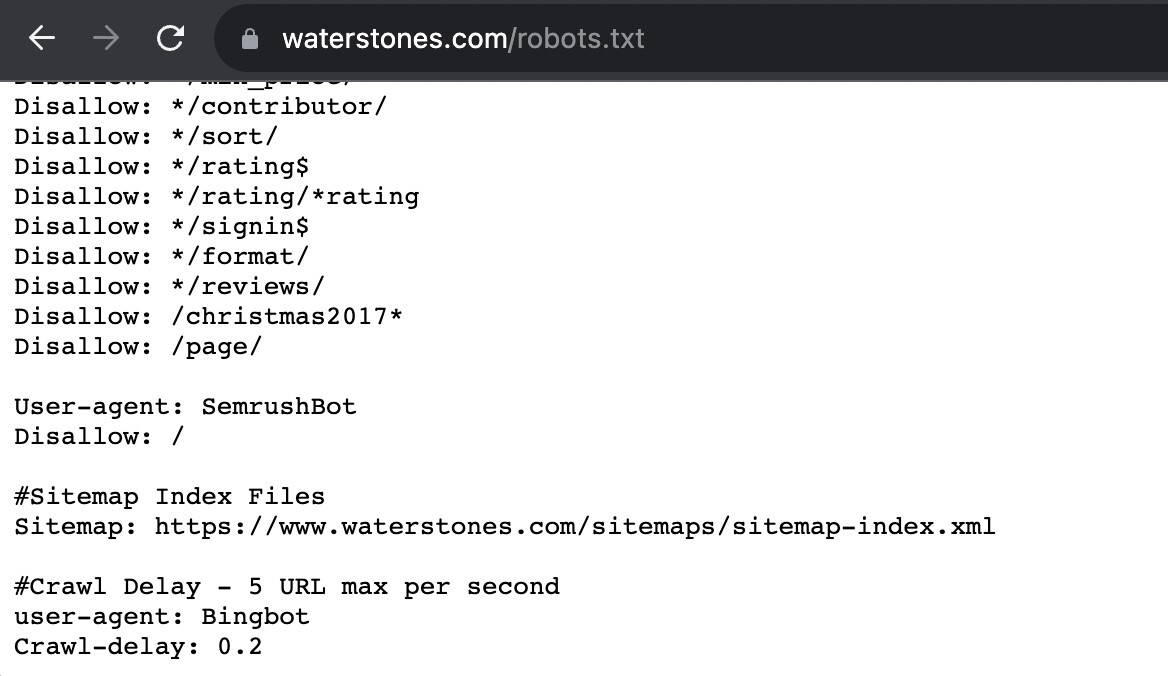

4.2. Cú pháp khác nhau tùy công cụ tìm kiếm

Mỗi công cụ tìm kiếm như Google, Bing, Yandex,… đều có những cách hiểu và xử lý riêng đối với các quy tắc được định nghĩa trong tệp robots.txt. Sự khác biệt này có thể xuất phát từ các thuật toán, cấu trúc dữ liệu hay đặc thù tìm kiếm khác nhau của từng công cụ.

Một số bot có thể không nhận diện đúng một số hướng dẫn nhất định, dẫn đến hành vi không mong muốn, ví dụ như lập chỉ mục những trang web mà bạn đang ngăn chặn. Chính vì thế, người quản lý website cần đảm bảo rằng cú pháp và quy tắc được áp dụng chính xác cho từng loại bot khác nhau. Mục đích nhằm tránh gây ra các vấn đề trong việc thu thập và lập chỉ mục dữ liệu.

4.3. Khả năng lập chỉ mục URL đã chặn trong robots.txt

Ngay cả khi một trang bị chặn trong robots.txt, điều này không hoàn toàn ngăn ngừa URL của các trang đó xuất hiện trên kết quả tìm kiếm. Nếu các trang khác có liên kết trỏ đến những URL bị chặn, các URL này vẫn có thể được lập chỉ mục trên Google dù cho nội dung của trang không được thu thập.

Ví dụ, bạn có trang A bị chặn trong robots.txt nhưng một trang B khác liên kết đến trang A. Khi bot tìm kiếm quét trang B, nó sẽ phát hiện ra liên kết đến trang A và thêm trang A vào danh sách các trang cần lập chỉ mục.

4.4. Không đảm bảo bảo mật thông tin tuyệt đối

Tệp robots.txt không phải là phương thức bảo vệ tuyệt đối đối với các nội dung nhạy cảm hoặc quan trọng. Nếu bạn muốn ngăn chặn hoàn toàn sự thu thập dữ liệu từ các bot, bạn cần áp dụng thêm các biện pháp bảo mật khác, chẳng hạn như:

- Sử dụng bảo vệ mật khẩu cho các tệp hoặc trang quan trọng.

- Sử dụng thẻ noindex để ngăn các trang bị lập chỉ mục.

- Thiết lập tiêu đề HTTP để từ chối lập chỉ mục.

- Xóa hoàn toàn trang khỏi máy chủ nếu không cần thiết.

Như vậy, để đảm bảo bảo mật tối đa và kiểm soát hoàn toàn việc thu thập dữ liệu, bạn cần kết hợp thêm các phương pháp bảo mật khác ngoài việc chỉ sử dụng tệp robots.txt.

5. Hướng dẫn tạo và gửi tệp robot.txt

Tạo và gửi tệp robots.txt cho website không phải là một quá trình phức tạp. Dưới đây là hướng dẫn chi tiết.

5.1. Với website sử dụng WordPress

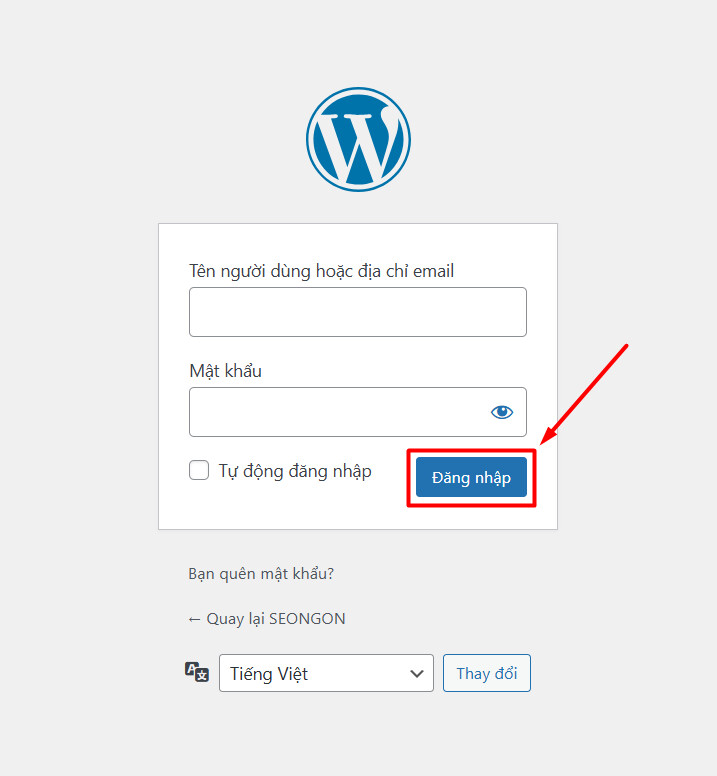

Đầu tiên, bạn cần xác định xem website của bạn có sử dụng WordPress hay không bằng cách thêm chuỗi “/wp-admin” vào cuối địa chỉ URL của trang web. Kết quả:

- Nếu là WordPress: bạn sẽ được chuyển đến trang đăng nhập của WordPress.

- Nếu không phải là WordPress: bạn sẽ nhận được thông báo lỗi hoặc trang không tồn tại.

Sau khi xác định được website sử dụng WordPress, bạn có thể thực hiện các bước sau:

Bước 1: Truy cập vào trang quản trị của WordPress và đăng nhập bằng tài khoản của bạn.

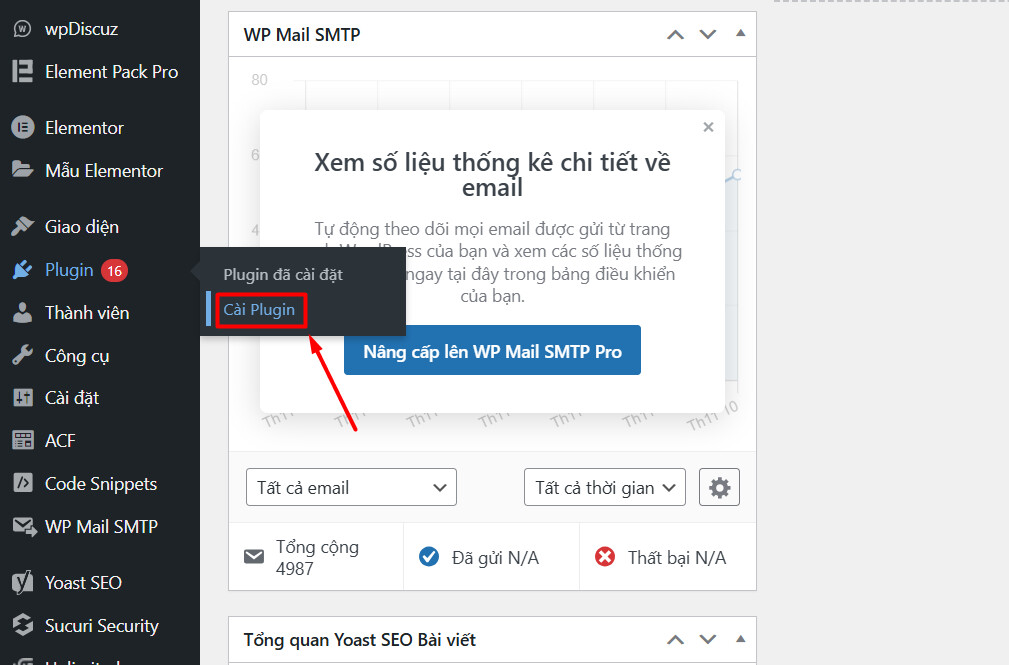

Bước 2: Thêm công cụ All in One SEO vào tài khoản WordPress của bạn.

Tại thanh menu bên trái bạn hãy di chuột đến phần Plugin và chọn Cài Plugin.

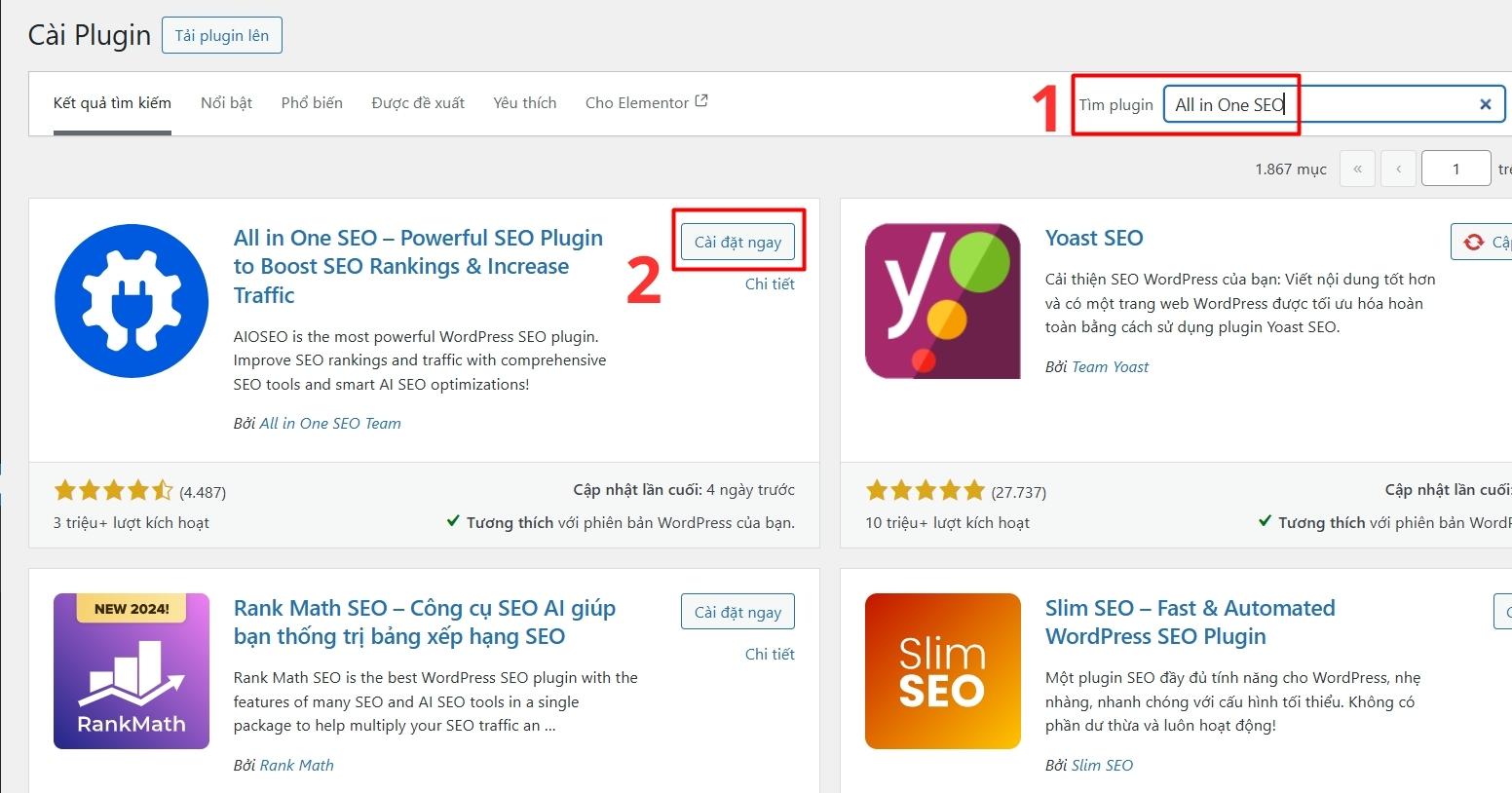

Trong giao diện của trang cài đặt bạn hãy nhập All in One SEO vào ô Tìm plugin và nhấn Enter >> chọn Cài đặt ngay.

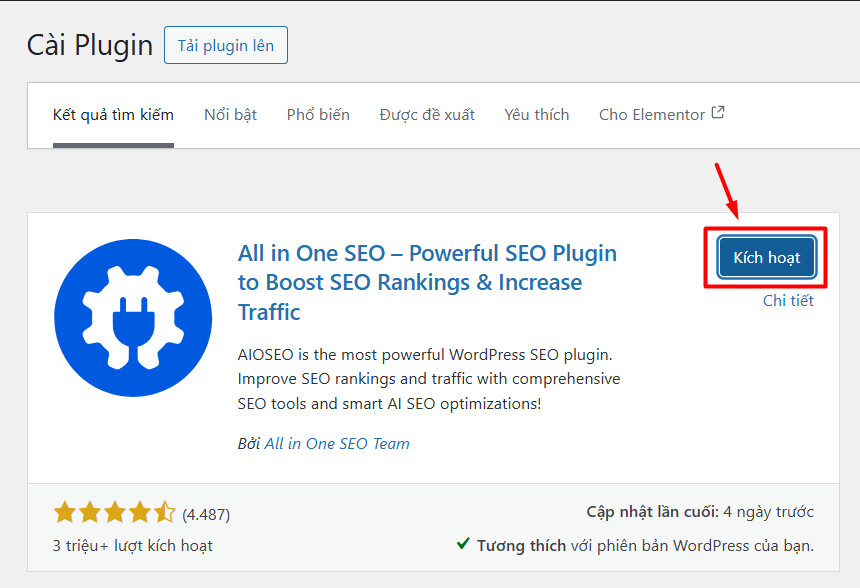

Khi quá trình cài đặt hoàn tất bạn hãy chọn Kích hoạt để tiếp tục việc thiết lập công cụ.

Chức năng của plugin này là giúp bạn dễ dàng tạo và quản lý tệp robots.txt mà không cần thao tác thủ công.

5.2. Tạo và gửi tệp robots.txt thủ công

Nếu bạn muốn tạo và gửi tệp robots.txt theo hình thức thủ công, dưới đây là quy trình cụ thể:

Bước 1: Tạo tệp robots.txt

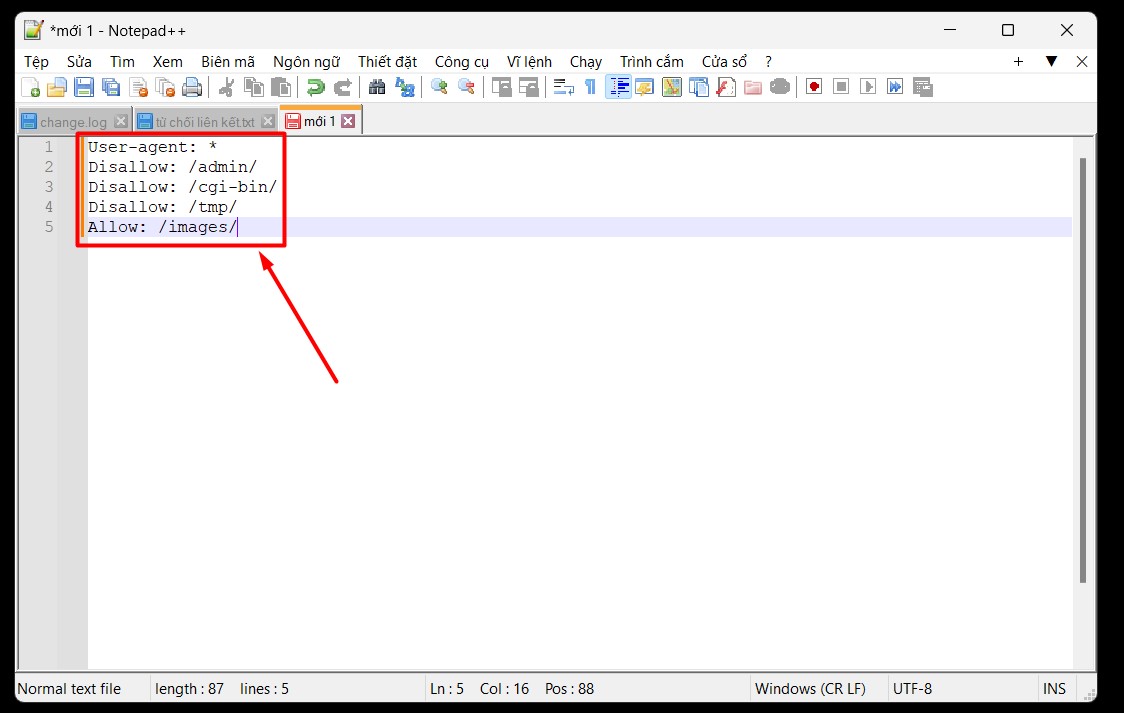

Để tạo tệp robots.txt bạn có thể sử dụng các trình chỉnh sửa văn bản dành cho lập trình như Notepad, TextEdit, vi, hoặc emacs.

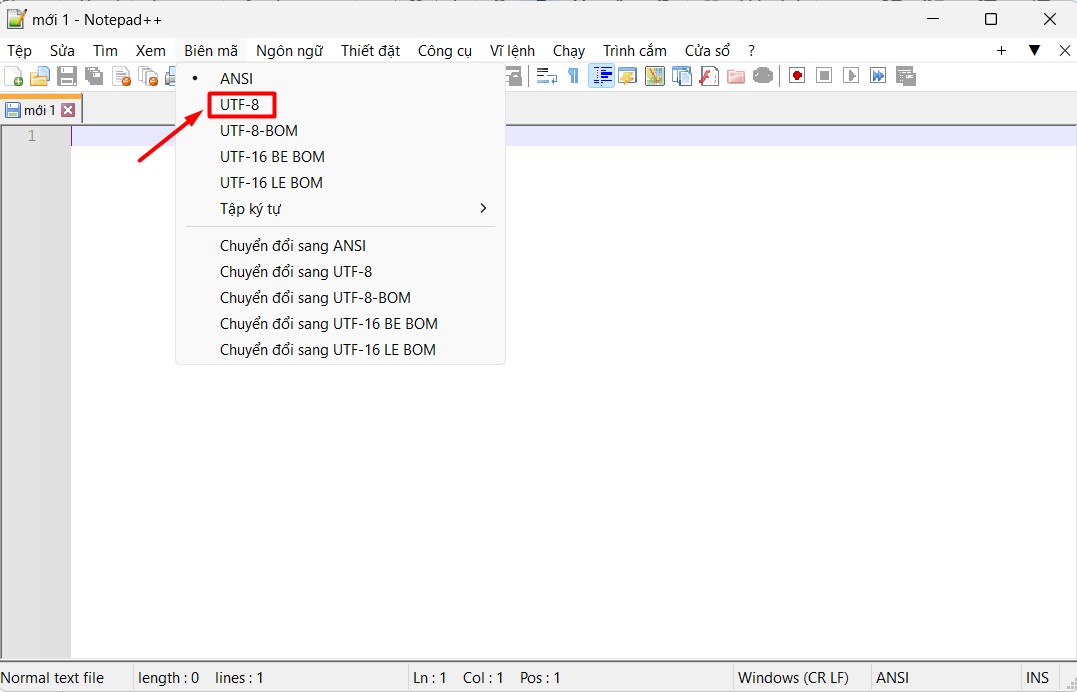

Lưu ý: Bạn nên chỉnh về dạng mã hóa UTF-8 để đảm bảo định dạng của file robots.txt luôn chính xác.

Bước 2: Viết quy tắc về định dạng và vị trí

Đặt tên tệp là robots.txt và lưu tại thư mục gốc của trang web (ví dụ: https://www.example.com/robots.txt).

Lưu ý: Mỗi website chỉ có thể có một tệp robots.txt và tệp này chỉ có hiệu lực cho miền hoặc cổng mà nó được lưu trữ. Ví dụ, https://example.com/robots.txt chỉ có hiệu lực cho https://example.com/ chứ không áp dụng cho miền con như https://m.example.com/.

Bước 3: Viết quy tắc trong tệp robots.txt

Cấu trúc tệp robots.txt bao gồm nhiều nhóm quy tắc, mỗi nhóm bắt đầu bằng dòng User-agent để chỉ định trình thu thập dữ liệu mà quy tắc sẽ áp dụng.

Các lệnh cơ bản:

- User-agent: Chỉ định trình thu thập dữ liệu cần áp dụng. Dấu* có thể được sử dụng để áp dụng cho tất cả các bot thu thập dữ liệu.

- Disallow: Chặn bot thu thập dữ liệu trên đường dẫn hoặc thư mục cụ thể.

- Allow: Cho phép bot thu thập dữ liệu trên một đường dẫn cụ thể, thường dùng để ghi đè lệnh Disallow.

- Sitemap: Chỉ định vị trí của tệp sơ đồ trang web (sitemap) để các công cụ tìm kiếm thu thập dữ liệu.

| Ví dụ về quy tắc:

Chặn tất cả các bot khỏi thu thập dữ liệu User-agent: * Disallow: / Chặn Googlebot truy cập một phần trang User-agent: Googlebot Disallow: /private/ |

Bước 4: Tải tệp robots.txt lên

Sau khi đã tạo tệp, bạn cần tải tệp robots.txt lên thư mục gốc của máy chủ website. Nếu bạn không có quyền vào máy chủ, hãy liên hệ đến nhà cung cấp dịch vụ để được hỗ trợ nhanh nhất.

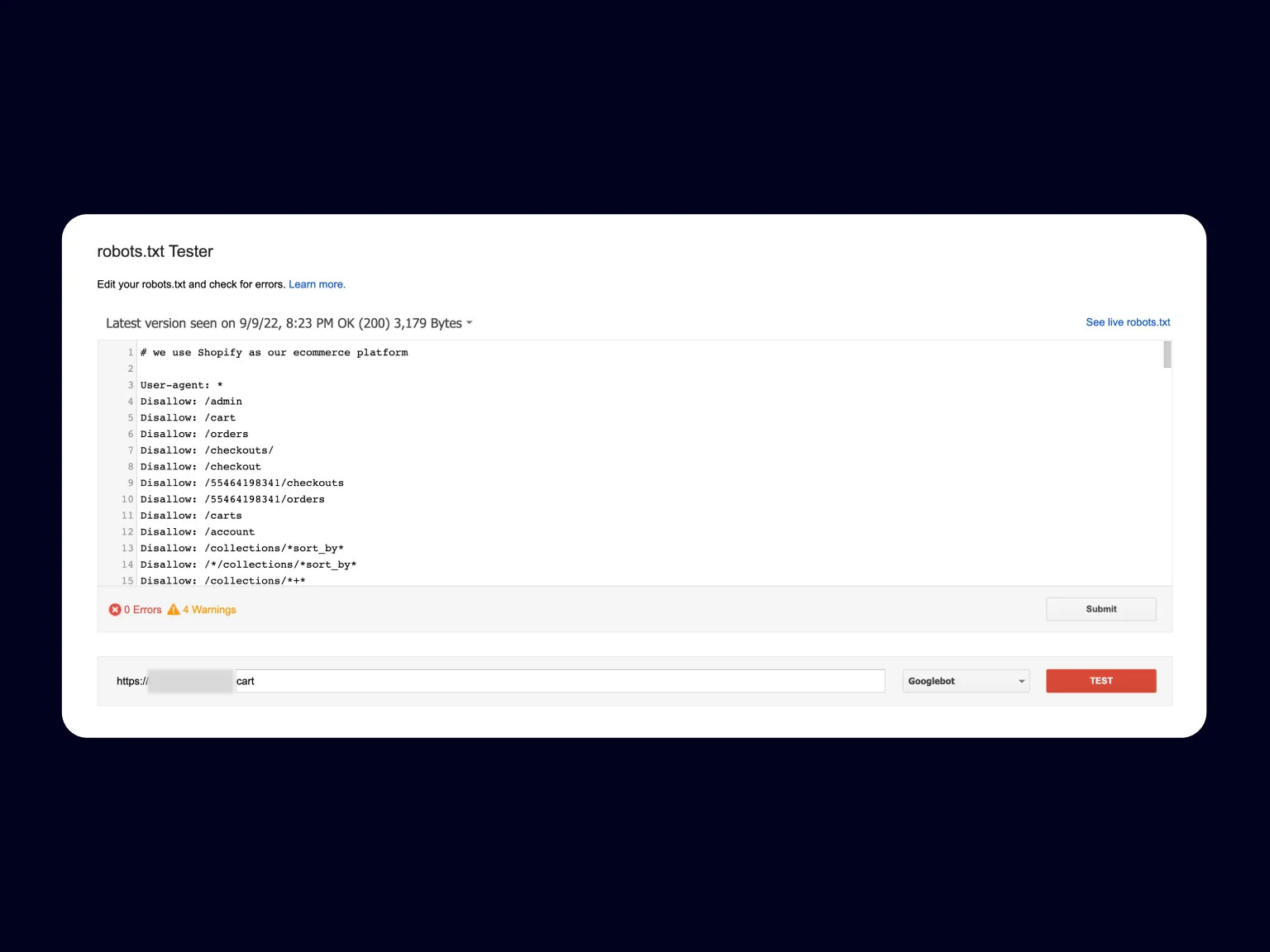

Bước 5: Kiểm tra và gửi tệp robots.txt cho Google

Kiểm tra tệp robots.txt bằng cách truy cập URL của tệp (ví dụ: https://example.com/robots.txt) hoặc sử dụng công cụ kiểm tra của Google Search Console.

Gửi tệp robots.txt cho Google: Google sẽ tự động phát hiện tệp robots.txt của bạn, nhưng nếu bạn cần làm mới nhanh chóng, bạn có thể yêu cầu Google cập nhật qua Google Search Console.

6. 8 lỗi thường gặp trong khi sử dụng file robot txt

6.1. Thư mục gốc không chứa Robot.txt

Không đặt tệp trong thư mục gốc của trang web là lỗi phổ biến nhất với robots.txt. Khi đặt sai vị trí, các bot không thể tìm thấy và không tuân theo các hướng dẫn của bạn. Lúc này, trang web sẽ hoạt động như là không có tệp robots.txt. Để khắc phục vấn đề này, bạn cần chuyển file robots.txt vào trong thư mục gốc của web.

6.2. Sử dụng ký tự đại diện kém

Robots.txt hỗ trợ hai ký tự đại diện là dấu hoa thị (*) và ký hiệu đô la ($). Tuy nhiên, việc sử dụng các ký tự này không đúng có thể vô tình dẫn đến việc chặn quá nhiều hoặc cho phép bot truy cập vào những trang bạn không muốn. Vì vậy, cần kiểm tra các quy tắc về ký tự đại diện với công cụ kiểm tra robots.txt để chắc chắn file đang hoạt động như mong muốn.

6.3. Noindex trong Robots.txt

Thêm một lỗi phổ biến SEOer thường gặp, đó chính là sử dụng lệnh noindex trong robots.txt với mục đích ngừng lập chỉ mục cho các trang web. Song, kể từ tháng 9/2019, Google đã ngừng hỗ trợ lệnh noindex trong robots.txt. Chính vì thế, các trang bạn sử dụng noindex vẫn có thể sẽ bị lập chỉ mục bởi Google. Để ngăn Google lập chỉ mục một trang, bạn cần sử dụng thẻ meta robots hoặc HTTP header x-robots-tag.

6.4. Chặn tập lệnh và bảng định kiểu

Chặn quyền truy cập vào các tệp biểu định kiểu xếp tầng CSS và JavaScript có thể khiến Google cũng như các nền tảng khác không thể phân tích đúng nội dung của trang web. Trong khi đó, các bot cần các tệp này để hiển thị trang web của bạn chính xác. Nếu bạn gặp vấn đề này, hãy đảm bảo không chặn quyền truy cập vào các tệp CSS và JavaScript cần thiết trong robots.txt.

6.5. Không có sitemap XML

Thêm một lỗi quan trọng nhiều người mắc phải, đó chính là không có URL của sơ đồ trang web XML. Mặc dù Google có thể tự tìm thấy sơ đồ trang web của bạn nhưng việc chỉ rõ đường dẫn này trong robots.txt giúp các bot tìm kiếm và thu thập dữ liệu từ trang quan trọng. Hãy cung cấp URL sơ đồ trang web trong robots.txt để tăng hiệu quả SEO.

6.6. Truy cập vào website phát triển

Không nên chặn hoàn toàn các công cụ tìm kiếm khỏi trang web nhưng việc để các bot truy cập và lập chỉ mục những trang web đang phát triển là điều không nên. Nguyên nhân vì chúng có thể chưa hoàn thiện hoặc chứa thông tin chưa chính xác và gây ảnh hưởng đến trải nghiệm người dùng. Để tránh điều này, bạn nên sử dụng hướng dẫn “Disallow” trong robots.txt để ngừng lập chỉ mục các trang đang phát triển và nhớ xóa lệnh này khi trang web chính thức ra mắt.

6.7. Sử dụng URL tuyệt đối

Một sai lầm phổ biến là sử dụng URL tuyệt đối thay vì đường dẫn tương đối trong tệp robots.txt. URL tuyệt đối có thể gây ra lỗi trong việc thực thi các quy tắc vì chúng không nhất thiết phải tương ứng với cấu trúc của trang web. Hãy sử dụng đường dẫn tương đối trong robots.txt để tránh gây nhầm lẫn cho các bot và chúng sẽ tuân thủ đúng các chỉ thị mà bạn đã đặt ra.

6.8. Một số phần tử không còn được dùng và không được hỗ trợ

Một số lệnh trì hoãn thu thập thông tin trong robots.txt đã không còn được hỗ trợ như “Trì hoãn thu thập thông tin” hay “Không lập chỉ mục”. Lệnh “noindex” trong robots.txt cũng đã bị loại bỏ từ năm 2019 bởi Google. Chính vì thế, bạn bạn cần phải thay thế các phương pháp này bằng các công cụ hoặc lệnh khác như thẻ meta robots hoặc X-Robots-Tag để đảm bảo các trang của bạn được xử lý đúng cách.

7. Câu hỏi thường gặp với file robots.txt

7.1. Một website có thể sử dụng nhiều tệp robots.txt không?

Mỗi website chỉ nên có duy nhất một tệp robots.txt và phải được đặt trong thư mục gốc của trang. Việc sử dụng nhiều tệp có thể gây nhầm lẫn cho các bot và làm gián đoạn quá trình thu thập dữ liệu.

7.2. Có thể chặn hoàn toàn một trang khỏi kết quả tìm kiếm nhờ Robot.txt không?

Tệp robots.txt chỉ có nhiệm vụ chỉ dẫn cho công cụ tìm kiếm, không phải lệnh bắt buộc. Nếu các trang khác liên kết đến trang bị chặn, Google vẫn có thể tìm thấy và lập chỉ mục nó. Để ẩn một trang khỏi kết quả tìm kiếm, bạn cần dùng thẻ meta noindex.

7.3. Sự khác biệt giữa tệp robots.txt và tệp sitemap.xml là gì?

- Tệp robots.txt: Dùng để hướng dẫn các bot về cách thu thập dữ liệu trên website của bạn.

- Tệp sitemap.xml: Dùng để cung cấp cho các bot một danh sách các URL quan trọng trên website, giúp chúng hiểu rõ cấu trúc trang web và thu thập dữ liệu hiệu quả hơn.

7.4. Nếu tôi muốn cho phép tất cả các bot thu thập dữ liệu, tôi nên viết gì trong tệp robots.txt?

Nếu bạn muốn cho phép tất cả các bot thu thập dữ liệu trên toàn bộ website, bạn có thể để trống tệp robots.txt hoặc sử dụng cấu trúc sau:

User-agent: *

- Allow: /

Như vậy, file robots.txt là công cụ hữu ích giúp bạn kiểm soát cách công cụ tìm kiếm thu thập dữ liệu trên trang web của mình. Việc sử dụng đúng cách sẽ giúp tối ưu hóa SEO và bảo vệ những phần nội dung không muốn hiển thị trong kết quả tìm kiếm.

Nếu bạn đang gặp khó khăn trong việc tối ưu hóa tệp này, hãy liên hệ ngay với SEONGON. Chúng tôi cung cấp dịch vụ SEO tổng thể toàn diện với quy trình làm việc chuyên nghiệp, hiệu quả giúp bạn nâng cao thứ hạng tìm kiếm và dẫn đầu ngành hàng của mình.